JetAcker ROS educational robot car uses Ackerman structure to support SLAM mapping navigation learning (Advanced Kit/Jetson Nano 4GB/A1 LiDAR)

举行活动

-

Kitronik FM Radio Kit V2.0

$15.23 -

Kitronik FM Radio Kit V2.0

$20.00

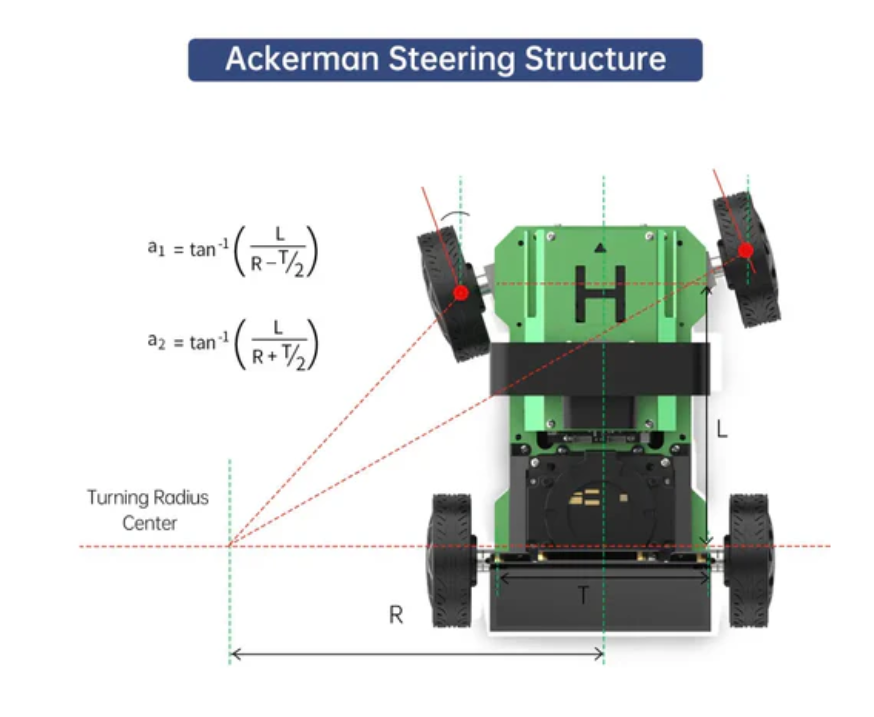

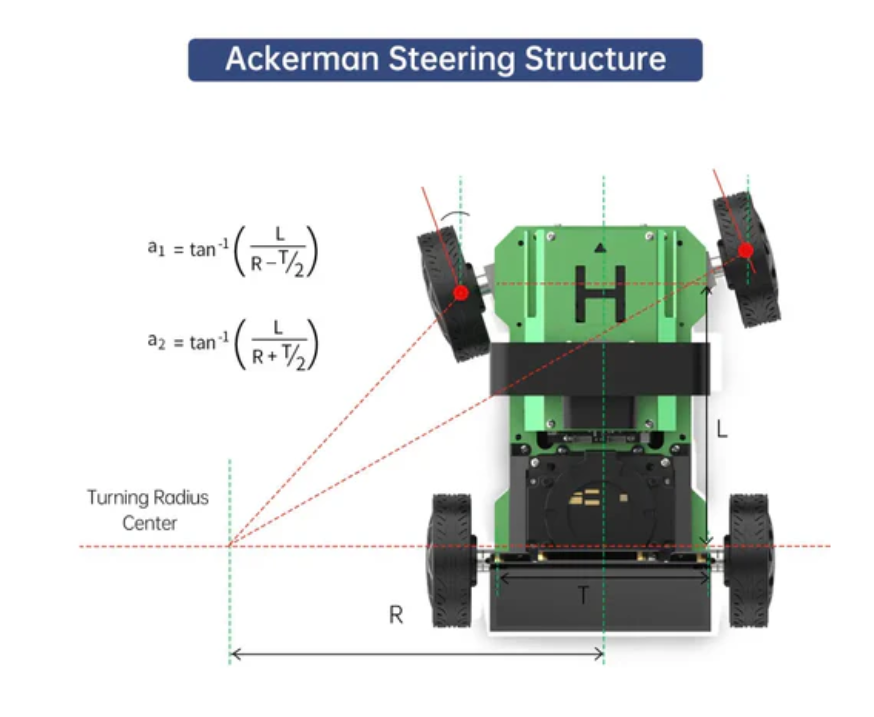

Adopting Ackermann chassis, it is very suitable for learning and verifying steering based robots

JetAcker is powered by NVIDIA Jetson Nano and supports ROS, deep learning, MediaPipe, YOLO, and TensorRT to perform advanced 3D vision tasks

JetAcker is equipped with a 3D depth camera and LiDAR, enabling remote control, 2D mapping, TEB path planning, and dynamic obstacle avoidance

Features include aluminum alloy frame, CNC steering, 100mm wheels, Hall encoder motor, and 6000mAh battery

Control JetAcker through WonderAi application (iOS/Android), wireless controller, ROS or keyboard

Product Description:

JetAcker is supported by NVIDIA Jetson Nano and supports Robot Operating System (ROS). It utilizes mainstream deep learning frameworks, combined with MediaPipe development, enables YOLO model training, and utilizes TensorRT acceleration. This combination provides a variety of 3D machine vision applications, including autonomous driving, motion sensing interaction, and KCF object tracking. In addition, with JetAcker, you can learn and validate various robot SLAM algorithms.

1) Ackermann steering structure pendulum suspension

The rear wheels of the chassis are always in a parallel state. When turning, the rotation angle of the inner wheel is greater than that of the outer wheel. Using the difference in rotation angle between the inner and outer wheels for steering is called Ackermann steering.

2) Equipped with LiDAR and supporting SLAM mapping navigation

JetAcker is equipped with a laser radar, which can achieve SLAM mapping and navigation, support path planning, fixed-point navigation, and dynamic obstacle avoidance.

3) Numerical Control Steering System

All metal CNC high-precision components combined with high load-bearing intelligent servo provide excellent rotational force.

4) High density solid wheel

Effective payload capacity, deformation resistance, reduced friction coefficient, and minimized mechanical wear, thereby extending service life.

5) Pendulum suspension structure

High precision swing suspension structure, balanced force distribution, good adaptability to uneven road surfaces, and will not cause any impact on the motor.

6) 240 ° high-performance gimbal

It is driven by a serial bus servo and provides overheat protection. Its rotation range of up to 240 ° expands the exploration range of JetAcker.

1. Dual control design, efficient collaboration

1) Main controller

-ROS controllers (JETSON, Raspberry Pi, etc.)

-Simultaneous Localization and Map Building (SLAM)

-Human computer voice interaction

-Advanced artificial intelligence algorithms

-Deep neural network

-AI visual image processing

2) Sub controller

-STM32 Robot Controller

-High frequency PID control

-Motor closed-loop control

-Sensor control and feedback

-IMU data acquisition

-Power status monitoring

2. Provide ROS1&ROS2 system images

ROS2 is an upgraded version of ROS1, which retains all the functions of ROS1 while supporting more operating systems and compilation environments, providing real-time control, enhanced modular development and testing, and more powerful features with a wider range of applications.

3. Lidar mapping and navigation

JetAcker is equipped with a laser radar, which supports path planning, fixed-point navigation, navigation obstacle avoidance, and multiple algorithm mapping, achieving radar guarding and tracking functions.

1) Lidar positioning

By combining the independently developed Lidar high-precision encoder and IMU accelerometer sensor data, JetAuto can achieve precise surveying and navigation.

2) Various 2D LiDAR surveying methods

JetAcker adopts various mapping algorithms such as Gmapping, HectorKarto, and Cartographer, and supports functions such as path planning, fixed-point navigation, and navigation obstacle avoidance.

3) Multi point navigation, TEB path planning

JetAcker uses LiDAR to detect the surrounding environment and supports robot applications such as fixed-point navigation and multi-point continuous navigation.

4) RRT autonomous exploration map

JetAcker adopts the RRT algorithm, which can independently complete exploration and mapping, save maps, and return to the starting point without manual control.

5) Dynamic obstacle avoidance

JetAcker can detect obstacles in real-time during navigation and re plan paths to avoid them.

6) Lidar tracking

Lidar enables robots to track targets by scanning moving objects ahead.

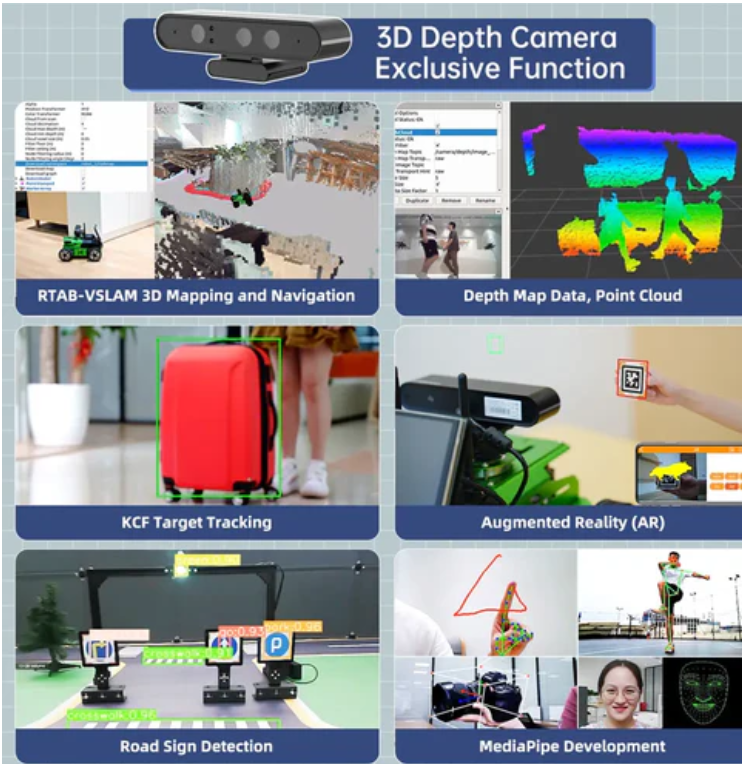

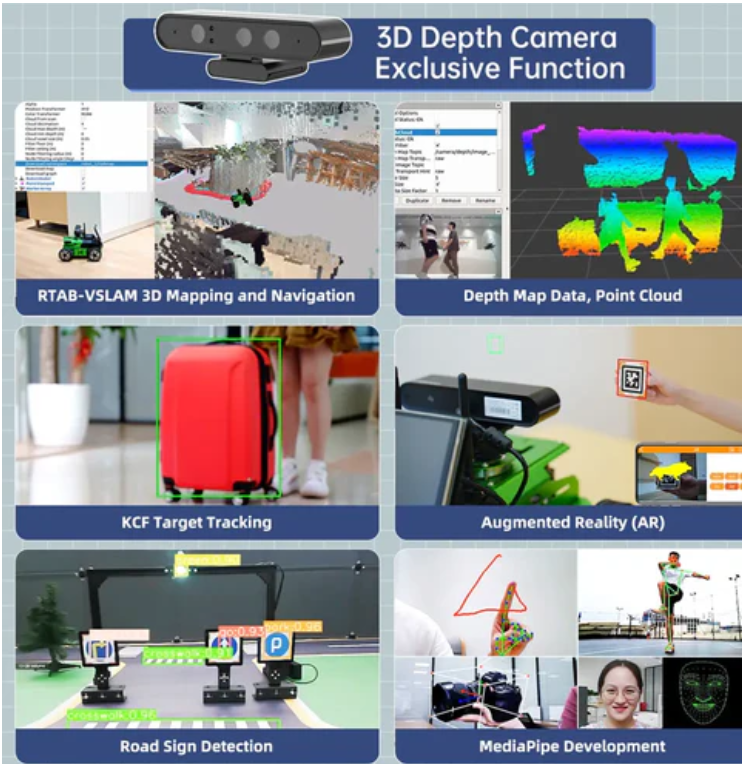

4. 3D Vision AI upgrade interaction

JetAcker is equipped with a 3D depth camera, supporting 3D visual mapping and navigation, and can obtain 3D point cloud images. Through deep learning, more AI visual interactive gameplay can be achieved.

1) 3D depth camera

JetAcker is equipped with Astra Pro Plus depth camera, which can effectively perceive environmental changes and achieve intelligent AI and human interaction.

2) RTAB-VSLAM 3D Visual Mapping and Navigation

JetAcker utilizes the RTAB SLAM algorithm to create 3D color maps, enabling navigation and obstacle avoidance in 3D environments, and supporting global positioning within the map.

3)ORBSLAM2 + ORBSLAM3

ORB-SLAM is an open-source SLAM framework for monocular, binocular, and RGB-D cameras, capable of real-time calculation of camera trajectories and reconstruction of 3D surrounding environments, and obtaining the true size of objects in RGB-D mode.

4) Depth map data, point cloud

Through the corresponding API, JetAcker can obtain depth maps, color images, and point clouds from the camera.

5. Deep learning and autonomous driving

JetAcker can achieve autonomous driving functionality through deep learning and is the perfect platform for learning the core functions of autonomous driving.

1) Road sign detection

JetAcker achieves AI vision based autonomous driving by training a deep learning model library.

2) Lane keeping

JetAcker is capable of identifying lanes on both sides and maintaining a safe distance from them.

3) Automatic parking

Combined with deep learning algorithms, JetAcker can recognize parking signs and automatically drive into parking spaces.

4) Transform decision-making

JetAcker will drive based on lanes, road signs, and traffic signals, while JetAuto will judge traffic conditions and decide whether to turn based on traffic signals.

6. MediaPipe development, AI interaction upgrade

JetAcker utilizes the MediaPipe development framework to implement functions such as human recognition, fingertip recognition, face detection, and 3D detection.

1) Fingertip trajectory recognition

2) Human body recognition

3) 3D inspection

4) 3D face detection

7. AI Visual Interaction

By integrating artificial intelligence, JetAcker can achieve KCF target tracking, route tracking, color/label recognition and tracking, YOLO object recognition, and more.

1) KCF target tracking:

By relying on the KCF filtering algorithm, robots can track selected targets.

2) Eye tracking:

JetAcker supports custom color selection, and the robot can recognize color lines and follow them.

3) Color/label recognition and tracking

JetAcker can recognize and track specified colors, and can simultaneously recognize multiple April tags and their coordinates.

4) YOLO object recognition

Utilize YOLO network algorithm and deep learning model library for object recognition.

8. 6CH far-field microphone array

This 6CH far-field microphone array excels in far-field sound source localization, speech recognition, and speech interaction. Compared with ordinary microphone modules, it can achieve more advanced functions.

1) Sound source localization:

By using a 6-microphone array, high-precision positioning of noise reduction sources can be achieved, and with radar distance recognition, Hiwonder can be summoned from any location.

2) TTS voice broadcast

The text content released by ROS can be directly converted into voice broadcasts for easy interaction design.

3) Voice interaction

Combining speech recognition with TTS voice broadcasting to achieve voice interaction and support the expansion of iFlytek's online voice dialogue function.

4) Voice navigation

Use voice commands to control Hiwonder to reach any designated location on the map, similar to the voice control scenario of a food delivery robot.

9. Interconnected formation

JetAcker can achieve multi aircraft formation performances and artificial intelligence games through multi aircraft communication and navigation technology.

1) Multi car navigation

JetAcker achieves multi vehicle navigation, path planning, and intelligent obstacle avoidance through multi machine communication.

2) Intelligent formation

A batch of JetAckers can maintain formation during movement, including horizontal lines, vertical lines, and triangles.

3) Group control

Only one wireless controller is needed to control a set of JetAckers, executing actions uniformly and simultaneously

8. ROS Robot Operating System

ROS is an open-source robot meta operating system that provides basic services such as hardware abstraction, underlying device control, commonly used function implementation, inter process message passing, package management, as well as tools and library functions required for cross computer code retrieval, compilation, writing, and execution. Its aim is to provide code reuse support for robot development.

10. Pavilion simulation

JetAcker is built on the Robot Operating System (ROS) and integrated with Gazebo simulation. This makes it possible to easily control robots in simulated environments, which helps with algorithm pre validation to prevent potential errors. Gazebo provides visual data that allows you to observe the motion trajectory of each endpoint and center. This visual feedback helps to enhance the algorithm.

1) Simulation control

Through robot simulation control, algorithm validation for mapping and navigation can be carried out, improving the iteration speed of the algorithm and reducing the cost of repeated experiments.

2) URDF model

Provide accurate URDF models and observe the mapping and navigation effects through Rviz visualization tools for easy debugging and algorithm improvement.

11. Multiple control methods

1) Python programming

2)WonderAi APP

3) Map navigation application (Android only)

4) Wireless controller